4.4 评估体系:从KPI到Evals

“你无法管理你无法衡量的东西。” 这句管理学的古老箴言,在 AI 原生企业时代获得了全新的、甚至可以说是更为严苛的解释。当我们管理的“员工”从情感丰富、需求多样的碳基人类,转变为由代码和数据构成的硅基智能体时,传统的人力资源绩效管理体系便在根基上被彻底动摇,直至轰然倒塌。我们正经历一场从主观、滞后、模糊的 KPI(关键绩效指标)到客观、实时、精准的 Evals(Evaluation Sets,评估集)的深刻变革。这不仅是评估工具的迭代,更是管理哲学的断代飞跃。

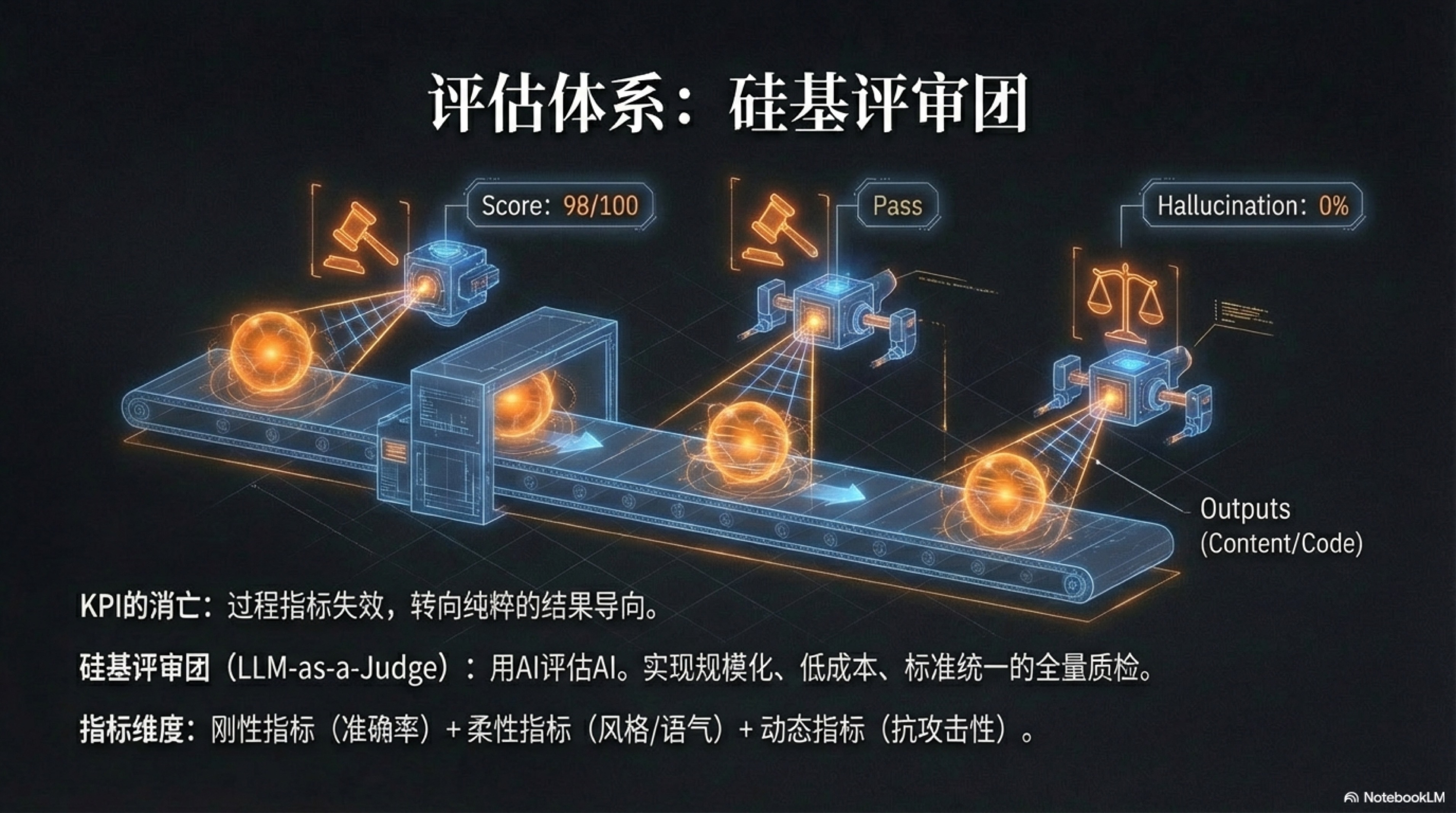

KPI的消亡:一场必然的告别

传统的 KPI 体系,本质上是工业时代和信息时代初期,为了管理和激励人类员工而设计的复杂契约。它试图通过一系列指标来量化人的贡献,但其设计的底层逻辑,却与 AI 智能体的存在方式格格不入。你无法考核一个 AI 的“工作态度”,因为它永远“态度端正”,绝对服从;你无法用“出勤率”来衡量它的价值,因为它 7x24 小时在线,永不疲倦;你更无法评估它的“团队协作精神”,因为它的协作模式由代码和协议严格定义,没有人类社会中的办公室政治或沟通障碍。

这些曾经在管理中占据核心地位的指标,在一夜之间变得荒谬。其根本原因在于,KPI 的很大一部分是为了解决“代理人问题”——确保员工(代理人)的目标与公司(委托人)的目标保持一致。它通过出勤、态度、协作等过程性指标,来约束和引导员工的行为,因为最终的“结果”往往受到太多不可控因素的影响,且难以精确归因。管理者寄希望于通过考核“正确的行为”,来间接导向“期望的结果”。

然而,AI 员工不存在“代理人问题”。它没有自己的私心、欲望或职业规划。它的唯一目标,就是其目标函数(Objective Function)所定义的目标。它不需要被激励,只需要被清晰地指令。对它进行过程管理是毫无意义的,因为它的“过程”就是代码的执行,是完全透明和可追溯的。因此,对 AI 的评估必须是,也只能是,纯粹的结果导向。一个 AI Agent 的价值,不在于它“看起来有多努力”,而在于它交付的结果是否精确、高效,以及是否为其投入的计算资源(Token 成本)带来了足够的回报(ROI)。这场告别是必然的,因为支撑 KPI 大厦的“人性”地基,已经被 AI 的概率性、确定性与无限算力彻底抽空。旧世界的地图,在新大陆上找不到任何可以导航的坐标。

三维Evals体系:为硅基员工打造的数字量尺

告别了 KPI,我们需要一套全新的、为 AI 量身定制的度量衡——Evals 体系。它不再是季度或年度的绩效回顾,而是嵌入到系统每一个角落、高频发生的自动化评估工程。一个全面的智能体评估体系,必须从三个维度展开,构建一个立体的、动态的质量坐标系,确保这支硅基军团在精确、高效、稳定的轨道上运行。

1. 刚性指标 (Hard Metrics):效率与准确的基石

这是评估体系的“承重墙”,是定义“对与错”的二元标准,不容任何模糊。它们是可被程序精确判断、非黑即白的客观事实。

- 任务成功率 (Pass Rate):这是最核心的根本。例如,一个负责代码生成的 Agent,其产出的代码是否通过了预设的单元测试?一个负责数据提取的 Agent,其生成的 JSON 文件是否完全符合预定义的 Schema 结构?这是“工作完成”的最低纲领,任何低于 100% 的成功率都意味着流程的中断和资源的浪费。

- 延迟与成本 (Latency & Cost):在 AI 的世界里,时间就是金钱,Token 就是预算。完成一次任务消耗了多少计算时间?调用了多少 Token?这些指标直接决定了业务的 ROI。一个虽然能完成任务但成本高昂的 Agent,在商业上可能是不可持续的。经济约束是强制 Agent 寻找最优解、防止成本失控的“数字缰绳”。

- 工具调用准确率 (Tool Usage Accuracy):在复杂的 Agent 系统中,AI 需要与各种外部工具(API、数据库)交互。它是否在正确的时间调用了正确的工具?传递的参数是否准确无误?错误的工具调用不仅会导致任务失败,还可能引发灾难性的下游效应。

2. 柔性指标 (Soft Metrics):质量与风格的灵魂

刚性指标定义了“合格”的底线,而柔性指标则追求“卓越”的上限。这些指标往往涉及主观判断,但在 AI 的辅助下,同样可以被大规模地量化。它们是品牌声音、用户体验和内容质量的守护者。

- 语气、风格与品牌一致性 (Brand Voice):一个代表公司与用户交互的客服 Agent,它的回复是生硬冰冷还是热情友好?它的语言风格是专业严谨还是活泼有趣?这直接关系到用户体验和品牌形象。在内容创作领域,Agent 生成的文章是否延续了创作者一贯的写作风格和核心观点?柔性指标确保了 AI 在规模化产出的同时,没有丧失其应有的“人格”或“调性”。

- 幻觉率与内容质量 (Hallucination Rate & Quality):这是大语言模型固有的风险。Agent 是否在回答中“编造”了不存在的事实?对于一个依赖 RAG(检索增强生成)的系统,其答案对原始知识库的“忠实度”有多高?内容是否有深度、有洞察,而不仅仅是事实的堆砌?这些质量维度的评估,防止了 AI 成为一个高产的“垃圾信息制造机”。

3. 动态指标 (Dynamic Metrics):对抗熵增的进化压力

这是一个经常被忽视,却至关重要的维度。它衡量的是智能体在时间长河中的稳定性与适应性,确保系统不会在无人看管的情况下悄然腐化。

- 模型漂移 (Model Drift):大语言模型作为一种服务,其底层模型会不断更新迭代。这可能导致曾经表现优异的 Prompt,在新版模型下的性能突然下降。动态指标通过建立一套固定的“黄金标准”评估集(Golden Dataset),定期回归测试,确保 Agent 的表现在模型更新换代中保持一致。这相当于为人类员工设立的“职业倦怠”或“状态下滑”的监控机制。

- 抗攻击性 (Robustness):系统需要面对外部世界的恶意。当遭遇恶意的 Prompt 注入攻击,或非预期的输入格式时,Agent 是否能保持其行为的稳定性和安全性?这衡量了系统的“免疫力”,确保它在真实、复杂的环境中能够稳健运行。

这三维 Evals 体系共同构成了一张动态的、多层次的评估网络,它将 AI 的表现数据化、实时化、透明化,为我们接下来要讨论的革命性评估方法——“硅基评审团”——提供了坚实的数据基础。

硅基评审团(LLM-as-a-Judge):规模化质量控制的唯一解

如何大规模、低成本且高效率地评估上述的 Evals,尤其是那些主观性极强的“柔性指标”?难道我们要雇佣成千上万的人类评审员,去批改 AI 生成的亿万份作业吗?这显然是悖论。答案,是用魔法打败魔法——使用 AI 来评估 AI。这便是“硅基评审团”(LLM-as-a-Judge)的核心理念,它不仅是一种技术,更是一种颠覆性的管理范式。1

想象这样一个场景:在一个全自动化的内容工厂里,过去需要一个庞大的人类编辑团队来审核稿件。主编A可能偏爱简洁的文风,副主编B则欣赏华丽的辞藻,实习生C则对语法错误格外敏感。他们的标准不一,状态时好时坏,下午三点昏昏欲睡时的审稿质量,与上午十点精神饱满时不可同日而语。而现在,这个编辑部被一个“硅基评审团”所取代。这个评审团由五个不同“性格”的 AI Agent 组成:

- “保守派法官”:它严格依据“刚性指标”,检查文章是否有事实错误、数据来源是否可靠,对任何可能引发争议的表述都持有最高警惕。

- “激进派创意官”:它专注于评估内容的“柔性指标”,判断观点是否新颖、角度是否独特、能否引发读者思考与讨论。

- “挑剔的语法学家”:它逐字逐句地检查语法、标点和风格一致性,确保文本的专业度和可读性。

- “品牌守护者”:它对照着“宪法”,评估文章的语气和价值观是否与预设的品牌声音(Brand Voice)完全一致。

- “用户共情师”:它模拟目标读者的视角,评估文章是否易于理解、是否有共鸣,预测其可能的市场反应。

当一篇由“写作 Agent”生成的稿件完成后,它会被瞬间分发给这个评审团。在一秒钟之内,五个“法官”同时从各自的维度进行审阅,并输出结构化的评分和修改意见。例如:“保守派法官”指出第三段引用的数据已过时;“激进派创意官”认为标题不够吸引人;“品牌守护者”则建议将某个过于口语化的词汇替换掉。这些反馈汇集起来,形成一份全面、客观、且标准高度一致的评审报告。2

这种模式的优越性是压倒性的:

- 规模与速度:人类评审员一天可能审阅几十篇文章,而硅基评审团一秒钟就能完成对成千上万份产出的高质量评估,将质量控制的瓶颈彻底打破。

- 一致性与客观性:AI 没有情绪,没有疲劳,没有偏见。只要“法官 Prompt”不变,它的评判标准就永远统一,彻底消除了人类评估中因主观因素导致的巨大方差。3 这种可重复性,是实现科学化、工程化管理的前提。

- 成本效益:与雇佣大量人类专家的成本相比,调用 LLM API 进行评估的成本几乎可以忽略不计。这使得“全量质检”从一种奢侈的理想,变成了廉价的现实。

硅基评审团的出现,标志着管理职能的一次深刻异化。管理者(或一人企业家)的角色,从一个具体的“审稿人”或“质检员”,转变为一个“评估体系的设计者”和“法官 Prompt 的撰写者”。你的工作不再是去评判每一个具体的结果,而是去定义“好”的标准,并将其代码化、自动化。这正是从 KPI 到 Evals 变革的终极体现:将质量控制本身,也变成了一段可以版本化管理、可以持续迭代、可以无限扩展的代码。在 AI 原生的世界里,这是通往规模化卓越的唯一路径。4

-

这篇文章清晰地解释了为何“LLM-as-a-Judge”被认为是当前最佳的LLM评估方法,其核心优势在于无可比拟的可扩展性、一致性与成本效益。参考 Confident AI Blog, “LLM-as-a-Judge Simply Explained”, Confident AI, 2023。文章链接:https://www.confident-ai.com/blog/why-llm-as-a-judge-is-the-best-llm-evaluation-method。 ↩

-

除了理论,具体的工程实现也至关重要。这篇教程提供了一份全面的实战指南,展示了如何一步步地构建和使用“LLM-as-a-Judge”来评估智能体(Agent)的输出质量。参考 Juan C. Olamendy, “Using LLM-as-a-Judge to Evaluate Agent Outputs: A Comprehensive Tutorial”, Medium, 2023。文章链接:https://medium.com/@juanc.olamendy/using-llm-as-a-judge-to-evaluate-agent-outputs-a-comprehensive-tutorial-00b6f1f356cc。 ↩

-

“硅基评审团“的一个关键应用场景是评估代码质量。这篇文章专门探讨了如何利用LLM作为“法官”来评估由其他LLM生成的代码,这是一个高度专业化且价值巨大的领域。参考 Cahit Barkin Ozer, “Utilising LLM-as-a-Judge to Evaluate LLM-Generated Code”, Softtechas on Medium, 2024。文章链接:https://medium.com/softtechas/utilising-llm-as-a-judge-to-evaluate-llm-generated-code-451e9631c713。 ↩

-

任何评估体系都有其局限性,“硅基评审团”也不例外。这篇文章深入研究了LLM作为“法官”时可能存在的各种偏见,如偏好更长的回答(冗长偏见)或位置靠前的回答(位置偏见),这对于我们设计更公平、更鲁棒的评估体系至关重要。参考 Wenxiang Jiao & Jen-tse Huang, “LLMs as Judges: Measuring Bias, Hinting Effects, and Tier Preferences”, Google Developer Experts on Medium, 2024。文章链接:https://medium.com/google-developer-experts/llms-as-judges-measuring-bias-hinting-effects-and-tier-preferences-8096a9114433。 ↩